是时候严肃对待人工智能监管问题了

是时候严肃对待人工智能监管问题了

去年底,OpenAI向全球推出了其大型语言模型ChatGPT,之后人们经历了狂热的6个月。从那之后,针对我们正在进行的全球性人工智能实验所带来的后果,我每天至少都会进行一次对话。我们还没有准备好,我指的是每个个体,包括个人、机构、政府,甚至是目前部署相关技术的公司。

未来生命研究所发布了一封呼吁暂停人工智能研究的公开信,人工智能领域的许多知名人士(包括一些著名的IEEE会员在内)都在该公开信中签名了。该公开信反映了一种态度,即从我们自己的利益考虑,我们的动作太快了。正如新闻经理玛格•安德森(Margo Anderson)在The Institute在线报道中所述,签名者包括IEEE高级会员、人工智能伦理大师埃莉诺•内尔•沃森(Eleanor “Nell” Watson)和IEEE会士、IBM软件工程首席科学家格雷迪•布奇(Grady Booch)。他告诉安德森:“这些模型正在被那些对其语料、架构、防护措施或处理用户数据政策不透明的公司肆意释放。我的经验和我的职业道德告诉我,我必须表明立场……”

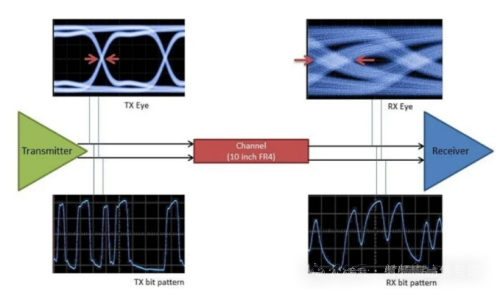

然而,研究和部署没有暂停,人工智能在一系列领域都变得至关重要。例如,资深编辑塞缪尔•K. 摩尔(Samuel K. Moore)在本期杂志第7页的《芯片设计中的丑陋部分》中介绍道,谷歌已经应用了深度强化学习来优化芯片上的逻辑和内存的位置。在本期杂志第24页的《人工智能勘探矿藏》一文中,KoBold Metals的联合创始人解释了他们是怎样使用机器学习模型来搜索电动汽车电池所需矿物的。

在拟议暂停研究和仓促应用人工智能之间,还存在着要求政府制定相关法规的社会、经济和政治挑战,这是由OpenAI的山姆•阿特曼(Sam Altman)和谷歌的桑达尔•皮查伊(Sundar Pichai)提出的。

为了帮助理解目前的人工智能状态,我与本刊资深编辑伊莉莎•斯特里克兰(Eliza Strickland)进行了交谈,她最近因其生物医学、地质工程和人工智能报道获得了Jesse H. Neal奖的最佳作家作品奖项。我们一致认为,诚信可能是近期最紧迫的问题。解决信息的来源及其可追溯性是关键。否则,人们可能会被大量不良信息淹没,以至于人类对于真实和虚假的脆弱共识完全破裂。

欧盟在人工智能的监管方面领先于世界,提出了《人工智能法案》。该法案将人工智能应用的风险分为3类:会产生无法接受的风险的应用应当被禁止、高风险应用程序应当受到严格监管、被认为几乎没有风险的应用程序不予监管。

虽然欧盟的《人工智能法案》涉及可追溯性和深度伪造,但并未具体涉及生成型人工智能,这是一种可以根据其训练数据生成高质量文本、图像或其他内容的深度学习模型。不过,计算机科学家杰伦•拉尼尔(Jaron Lanier)最近在《纽约客》上发表的一篇文章直接探讨了生成型人工智能系统中的来源和可追溯性问题。

拉尼尔将生成型人工智能视为一种社会协作,它将人类所做的工作融合在了一起。他帮助开发了一个名为“数据尊严”的概念,可以将其大致理解为,对于机器生成的此类产品,如果能够追溯到人类的数据源,应当标记出相关人员的贡献。“在这个理念的某些版本中,人们可以因自己创造的内容而获得报酬,即使这些内容通过大型模型进行过滤和重组了,技术中心也会就促进人们达成所愿而收费。”拉尼尔写道。

现在,这是一个值得探索的理念。可惜的是,我们无法促使ChatGPT制定一个全球性的监管制度来指导我们如何将人工智能融入生活。法规最终适用于目前具有话语权的人类,只有我们才能确保人类和机器有一个安全和繁荣的未来。

作者:Harry Goldstein

关注微博

关注微博 关注微信

关注微信 关注公众号

关注公众号 关注抖音号

关注抖音号