天华中威科技微波小课堂_为什么毫米波雷达无法识别静态物体

毫米波雷达传感器融合的困境

问题不在于毫米波无法识别静态物体,而是在于毫米波自己分辨率低,噪声多,无法正确识别静态物体的位置,也很难结合前方车道几何形态正确判断是否需要躲避。

其实不用大段文字介绍毫米波原理,以目前比较主流的自动驾驶公开数据集NuScenes的真实数据为例就可以非常容易的理解这个道理。NuScenes使用的是比较标准的一个前雷达,4个角雷达的5毫米波雷达配置,在绝大多数当前可以买到的带辅助驾驶功能的产品中,基本都用了类似配置。这里我们不谈4D毫米波,目前还比较少见,未来是否大规模应用也受成本,产能以及其他可选替代传感器的相对性价比影响,比较难以判断。

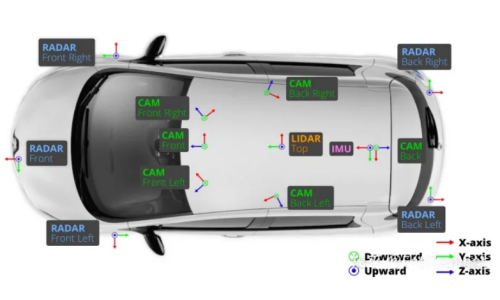

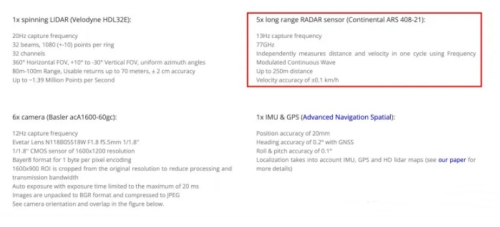

NuScenes公开数据集使用的L4级别的传感器配置,其中包含5个毫米波雷达

NuScenes数据集使用德国大陆公司的ARS 408毫米波雷达

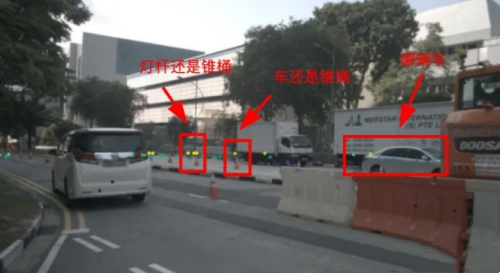

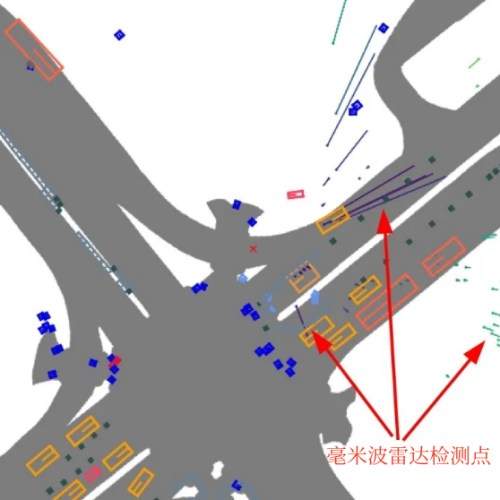

找一个NuScens中的场景数据是如下这样的。

相机检测框可视化在图片上

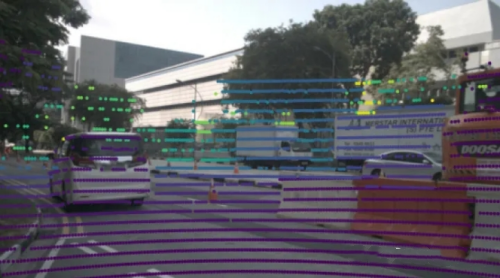

毫米波雷达数据点可视化在图片上

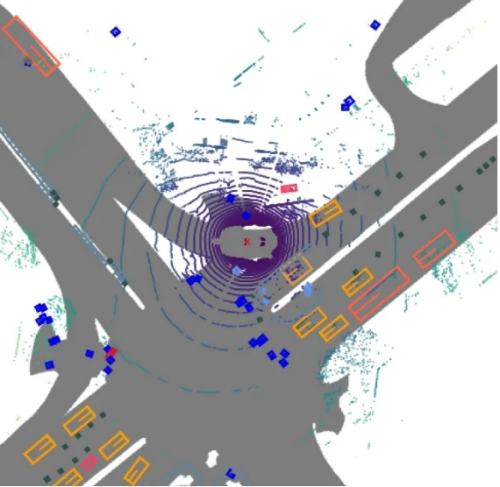

激光雷达电云可视化在图片上

根据同一场景的三幅可视化图片可以发现,毫米波雷达在高度上是缺失的,而且目标点密度很低,远低于激光雷达,所有目标检测点是堆在一维线上的,由于毫米波雷达信息很少,一般在指导自动驾驶决策规划的之前要和视觉还有激光雷达进行融合。

OK,现在读文章的同学可以自己尝试下把上面视觉检测框和毫米波检测点进行一下关联,要知道人脑目前还是远远比AI算法更聪明,如果你们智商和我差不多,那么我没有信心准确对所有检测框和毫米波测量点进行观测。

那如果投影到自车坐标系下呢?

毫米波雷达检测点与视觉检测框可视化在自车坐标系

激光雷达点云与视觉检测框可视化在自车坐标系

那么会发现,和Lidar不同,毫米波检测点位置并不准确,也非常稀疏,另外还有大量噪声,即使在自车坐标系下仍旧很难和视觉检测框正确关联。

那么如果人都无法百分百确定正确关联关系,算法也就更无法保证时刻关联正确了!!!

辅助驾驶功能对传感器融合错误的妥协

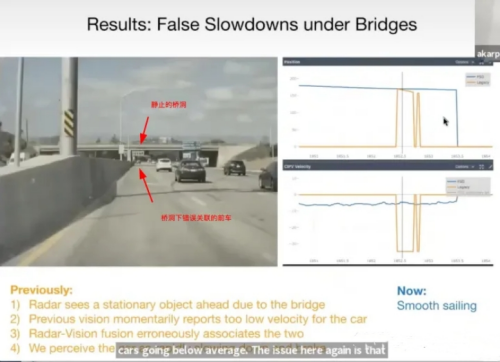

Karpathy分享过的一个错误匹配导致幽灵刹车的案例

上图是前Tesla AI 视觉总监Andrej Karpathy再分享他们用视觉替代毫米波雷达的逻辑的时候举过的一个例子。

先讲下背景,因为要保持自车舒适以及对于危险的预判和保护性驾驶,所以一般在辅助驾驶功能时候前车大幅度减速时候,即使离自车比较远,自车也要做相应的减速操作,以减小后续急刹以及后续碰撞追尾风险。

所以这里就是因为毫米波高度上没有足够分辨率,当前车经过桥洞下时候,这时候分别属于前车和前方静止桥洞的毫米波检测被错误的匹配了视觉目标,由于毫米波雷达能够给出前车相对自车速度,那么这种情况下错误匹配成前车的桥洞点就会告知自车,前车突然刹停,这时候最合理的操作就是开始减速,造成所谓的“幽灵刹车”。

上面场景实际非常普遍,高速上有很多静止物体会触发毫米波回波形成检测点,比如桥洞,龙门架,地面的井盖,在前车经过这些静止物体的时候就很容易触发无匹配,从而造成幽灵刹车,严重甚至造成后车追尾。

为了减少幽灵刹车,车企只能选择降低对完全静止物体毫米波量测的置信度,因为毕竟是L2辅助驾驶,要求驾驶员时刻关注路况。这样当前方真的出现静止障碍物的时候,辅助驾驶就有可能忽略这一毫米波雷达检测,导致自车不制动了。这也是很多公司现在选择安装前向激光雷达,以及Tesla选择利用视觉Occupancy Network以及视觉物体速度加速度估计,来避免此类问题的原因。

关注微博

关注微博 关注微信

关注微信 关注公众号

关注公众号 关注抖音号

关注抖音号